Hablar de Big Data en un ámbito no tecnológico significa hablar de muchos datos, mucha información, y a menudo, de un cierto miedo debido a la información que puede extraerse de tantos datos.

Si nos centramos en este último aspecto, entramos dentro de las teorías conspiratorias de grandes corporaciones y gobiernos para poder espiar a los clientes y a los ciudadanos.

El objetivo de este artículo es ofrecer una visión general de esta realidad relacionando Big Data con la ética.

Análisis avanzado

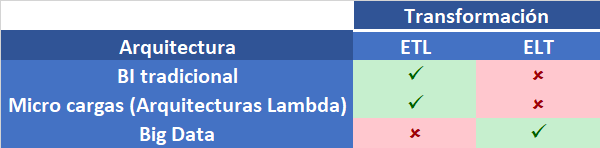

Big Data permite analizar una gran cantidad de datos, más allá de los límites del Business Intelligence (BI) tradicional.

Disponer de un gran volumen de datos abre la puerta al análisis avanzado de éstos. Entre estos análisis avanzados encontramos la obtención de correlaciones entre variables, creación de modelos predictivos, agrupación en base a diferentes técnicas como clasificación, clustering, etc.

Con esta capacidad de análisis, es posible obtener información que en el pasado, por las limitaciones del BI tradicional, no era posible obtener. Esto significa un mejor conocimiento de las fuentes de información y sus relaciones, y una mejor base de conocimiento.

Mejor toma de decisiones

El hecho de disponer de más y mejor conocimiento implica una mejora en la toma de decisiones por parte de las organizaciones.

Es obvio que las organizaciones desean obtener el máximo nivel de detalle en su búsqueda de conocimiento. De esta manera, pueden tomar decisiones más ajustadas a cada uno de los individuos (clientes, habitantes, etc.) del estudio analítico.

El objetivo de las organizaciones está, en parte, en la eficiencia de sus procesos y la maximización de los beneficios, ya sea económicos (en empresas) como de servicio a los individuos (en la administración) y reducción de costes. Y esa eficiencia es directamente proporcional al nivel de detalle del conocimiento sobre el cual se basan las decisiones. Por ejemplo, no es lo mismo tomar decisiones a partir de datos globales sobre los clientes de una empresa que sobre cada uno de ellos.

Ante esta premisa, es evidente que el deseo de las organizaciones es el de llegar a un nivel de detalle alto para poder tomar las mejores decisiones.

Uso de la información

Un alto nivel de detalle puede llegar a suponer la trazabilidad de los individuos hasta la mínima expresión.

Un escenario donde queda patente este nivel de detalle es el de los datos que pueden ser obtenidos a partir de los teléfonos móviles. Algunos ejemplos de datos generados a partir de un teléfono móvil son las llamadas, la geolocalización, la navegación web y la actividad en redes sociales. El volumen de datos generado tan solo con estas aplicaciones es inmenso y está asociado a un individuo.

¿Implica ese nivel de detalle y la toma de decisiones sobre estos datos un problema ético? Veamos un ejemplo a partir de las llamadas de teléfono.

La compañía telefónica, el fabricante del móvil y hasta el fabricante del sistema operativo del móvil podrían tener acceso a las llamadas que realizamos y recibimos. El uso de esta información está totalmente prohibido por ley excepto en el caso de existencia de una orden judicial que autorice a las fuerzas del estado a monitorizar o analizar esa información y hasta a realizar escuchas. Por tanto, ¿es posible que las empresas con acceso a estos datos los usen con un nivel de trazabilidad a nivel de usuario? Posible es, pero el riesgo penal por el uso de esos datos es tan alto que es lógico pensar que una organización no hará uso de esa información. Es más, el mero hecho de almacenar esa información es un alto riesgo para la organización en caso de ataque informático que deje al descubierto esa información. Cierto es que las compañías telefónicas deben almacenar el registro de llamadas de manera centralizada como parte de su sistema de facturación, pero el resto de empresas citadas no lo necesitan. En su caso, su uso seguramente se restringe a la obtención de información agregada para la mejora de procesos en su hardware y software.

Permisos de explotación de datos

Otro tema a tener en cuenta es el de los permisos que los usuarios otorgan a las organizaciones para el uso de los datos.

¿Quién no se ha leído toda la letra pequeña a la hora de firmar un contrato? ¿Quién no ha aceptado las condiciones de uso de un dispositivo o de un software sin leerse todo el contrato? Os recomiendo, como curiosidad, este artículo sobre la letra pequeña.

En estos contratos, por lo general, el usuario acepta que el proveedor pueda recabar datos de uso con diversos fines. Entre éstos se puede encontrar el uso comercial y la venta de datos a terceros. Por tanto, al aceptar las condiciones estamos cediendo esos datos para su uso.

En otras palabras, parte de ese riesgo en la explotación de datos corresponde al usuario, que cede los datos generados de manera individual.

Conclusión

El potencial de Big Data al tratar datos masivos abre la puerta a la realización de análisis avanzado. Éste permite la toma de decisiones con un nivel de detalle mínimo.

La trazabilidad de los individuos es posible con este detalle mínimo, lo cual justifica la existencia de dudas respecto a la privacidad del individuo.

La cesión de datos corresponde únicamente al individuo y la realiza por voluntad propia.

Cualquier actividad que viole el contrato de aceptación de datos es punible, ya que la ley no permite el uso de datos personales sin el consentimiento del individuo.

La ética es un concepto ambiguo que depende de cada individuo. Ante la duda sobre la ética de la organización a quien cedemos nuestros datos, probablemente lo mejor sea no cederlos.